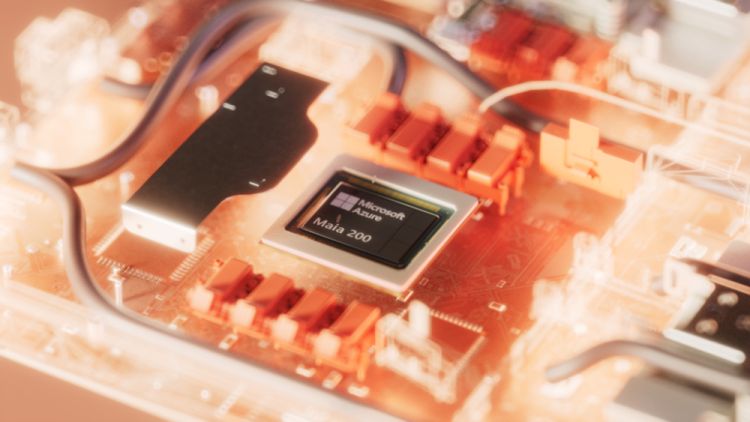

Der neue Microsoft-Chip Maia 200 soll in seiner Funktion als Inference Accelerator die Generierung von KI-Tokens im Umfeld von Azure dramatisch beschleunigen, wie es in der Mitteilung heisst. Microsoft bezeichnet den Chip als bahnbrechend. Er wird im 3-nm-Prozess von TSMC gefertigt, verfügt über native FP8/FP4-Tensor-Kerne und ein neu konzipiertes Memory-System mit 216 GB HMB3e-Speicher bei 7 TB/s Durchsatz sowie 272 MB On-Chip-SRAM.

Laut Microsoft ist Maia 200 der leistungsfähigste Chip, der direkt von einem Hyperscaler stammt. Er biete gegenüber dem Amazon Tritanium der dritten Generation das Dreifache an FP4-Performance (über 10 PetaFLOPS) und liege bei der FP8-Leistung (5 PetaFLOPS) über der Google-TPU der siebten Generation. Im Vergleich zur aktuellen Hardwaregeneration, die bei Microsoft im Dienst steht, soll Maia 200 30 Prozent mehr Performance bieten. Insgesamt, so

Microsoft, könne ein Maia 200 die momentan grössten KI Modelle mühelos ausführen und habe reichlich Spielraum für grössere Modelle der Zukunft.

Mit Einführung des neuen Chips stellt Microsoft auch eine Vorschau des Maia Software Development Kits bereit. Das SDK unterstützt gängige KI-Frameworks und soll Entwicklern dabei helfen, ihre Modelle gezielt für den Einsatz auf Maia-Systemen zu optimieren. Das SDK umfasst einen Triton-Compiler, Support für PyTorch, NPL-Programmierung sowie einen Simulator und Kostenrechner.

Systeme mit Maia 200 stehen zuerst in US-Regionen von Microsoft Azure zur Verfügung und sollen zunächst für KI-Modelle des Microsoft Superintelligence Teams sowie für Projekte wie Azure AI Foundry und Microsoft 365 Copilot zum Einsatz kommen.

(ubi)