Entwickler

Haftung nach dem ProduktehaftpflichtgesetzNach dem Produktehaftpflichtgesetz kurz PrHG haftet der Produktehersteller (Entwickler) für fehlerhafte Produkte. Software ist grundsätzlich ein Produkt im Sinne des PrHG. Ein Produkt ist fehlerhaft, wenn es nicht den berechtigten Sicherheitserwartungen eines Durchschnittskonsumenten entspricht. Diese Fehlerhaftigkeit muss im Zeitpunkt des Inverkehrbringens vorliegen. Bei lernfähigen KI-Systemen gibt es daher ein paar Besonderheiten. Zum einen stellt sich die Frage, ob der Hersteller überhaupt für Fehlentscheidungen einer KI haften soll, da das Fehlermachen für solche Systeme geradezu charakteristisch ist. Für eine Haftbarkeit spricht, dass die Lernprozesse auf Algorithmen beruhen, die im Zeitpunkt des Inverkehrbringen Bestandteil des Produkts waren. Damit legt der Entwickler die Weichen für die Entwicklungsfähigkeit und eine daraus folgende Schädigung. Möchte der Entwickler eine Haftung vermeiden, muss er das KI-System so konstruieren, dass systemimmanente Sicherheitsrisiken soweit wie möglich vermieden werden. Ausserdem haftet der Entwickler nicht für Entwicklungsrisiken, also wenn im Zeitpunkt des Inverkehrbringens die Gefährlichkeit des Produkts weder bekannt noch erkennbar war. Allerdings sind die Risiken von möglichen der KI zumindest abstrakt bekannt. Im Kontext von Legal AI’s jedoch ist die Geltendmachung von Ansprüchen aus dem PrHG jedoch unwahrscheinlich, da ein Personenschaden bzw. ein Sachschaden an einem Produkt des privaten Gebrauchs vorliegen muss. Es scheint unwahrscheinlich das der Gebrauch einer legal AI zum Tod oder Verletzung einer Person bzw. zu einem Sachschaden an einem Gegenstand des persönlichen Gebrauchs führt.

Haftung nach UrheberrechtVerfügen die Entwickler nicht über entsprechende Nutzungsrechte, können Inputdaten, welche für das Training von KI-Systemen oder zur Generierung von Output verwendet werden, allenfalls Urheberrechte Dritter verletzen.1 Hier ist fraglich, ob das blosse Trainieren der KI ein urheberrechtliches Vervielfältigen darstellt, da das reine Trainieren, ohne Werkgenuss eines Menschen geschieht (dieser entsteht erst in Kombination mit einem Prompt). Es könnte weiter die sogenannte Wissenschaftsschranke greifen, indem die Daten zu Forschungszwecken trotz urheberrechtlichen Schutz Dritter verwendet werden dürfen. Grundsätzlich ist dies zu bejahen, da die Daten zu einer neuen Erkenntnis führen.2 Wichtig ist das die Wissenschaftsschranke nicht für Computerprogramme gilt. Da KI-Systeme kreativ sind, sind diese nicht als herkömmliches Computerprogramm zu qualifizieren3.

Vertragliche Haftung im Verhältnis zwischen Entwickler und NutzerAllgemeine VertragshaftungEs können Gewährleistungsrechte des Nutzers gegenüber dem Entwickler greifen. Dabei muss ein Mangel vorliegen, also eine Abweichung vom Problematisch ist die Einordnung von nicht erwünschtem Verhalten der KI, das auf die Lernfähigkeit zurückzuführen ist. Wie bei der Produkthaftung, muss der Mangel zur Zeit des Gefahrenübergangs vorliegen. Ist die Weiterentwicklung des Programmcodes fehlerhaft, ergibt sich das Fehlverhalten erst nach dem Gefahrenübergang. In diesem Fall liegt die Verantwortung beim Nutzer. Reagiert das System, trotz einwandfreiem Programmiercode, in einer Weise, welche den Erwartungen des Nutzers nicht entspricht, ist zu unterscheiden. War die Reaktion voraussehbar, so haftet der Entwickler. War die Reaktion unvorhersehbar oder innerhalb des Entscheidungsspielraums, so ist der Nutzer dafür verantwortlich.4

Ausservertragliche HaftungWeiter könnte die deliktische Haftung gegenüber dem Entwickler greifen. Im Zusammenhang mit KI ist die Bestimmung des Schädigers besonders komplex. Die, durch das KI-System verursachten Schäden müssen einer natürlichen oder juristischen Person zugerechnet werden.5 Es kommen daher mindestens zwei mögliche Schädiger in Betracht: dem Entwickler und dem Anbieter. Bei der Entwicklung des KI-Systems muss der Entwickler mit angemessener Sorgfalt vorgehen.

Benutzer

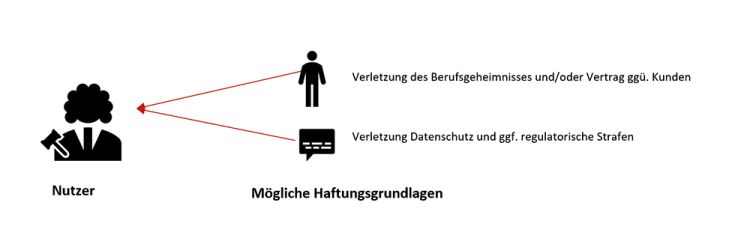

Haftung für AnwaltsgeheimnisverletzungUnter das Berufsgeheimnis fallen alle Angaben, die auf ein Mandat oder dessen Inhalt schliessen lassen. Bei einer sogenannten On-Premise Lösung wird die KI-Anwendung im eigenen Netzwerk installiert und betrieben. Bei dieser Lösung verlassen grundsätzlich die Eingaben und Informationen das interne Netzwerk nicht und Dritte haben generell keine Einsicht in die Daten. Bei einem Outsourcing sollte sichergestellt werden das die Datenschutzrechtlichen Regeln des Outsourcings gemäss Datenschutz und SAV (Schweizerischer Anwaltsverband) eingehalten werden. Der Zugriff sollte auf das minderst nötige reduziert werden und klar dokumentiert werden und angemessene technische und organisatorische Massnahmen (TOMs) implementiert werden. Ein Datenschutzmanagementsystem im Hinblick auf die KI ist erforderlich. Weiter kann natürlich auch eine Einwilligung bzw. Verzichtserklärung des Klienten eingeholt werden6.

Datenschutz (DSG)Sobald Personendaten in das System eingegeben werden ist das DSG anwendbar. Ein Grossteil der Anwaltskanzleien vertraut auf KI-Systeme von externen Anbietern. Dabei findet die Kommunikation der Eingaben mit einem fremden Server statt (Outsourcing/Cloud-Lösung). Dies hat zur Folge, dass die eingegebenen Daten den eigenen Kontrollbereich verlassen und von einem Dritten bearbeitet werden. Die eigenen Eingaben sollten nicht zu externen Trainingszwecken verwendet werden. Zum anderen sollte mit dem Entwickler ein Auftragsdatenbearbeitungsvertrag (ABV) abgeschlossen werden. Falls der Entwickler in einem Land mit unzureichendem Datenschutzniveau ansässig ist, sollten zusätzlich entsprechende Absicherungen getroffen werden. Verletzungen des Datenschutzes können mit Bussen von bis zu CHF 250’000 bestraft werden.

Vertragliche Haftung im Verhältnis zwischen Nutzer und MandantHaftung aus AuftragZwischen Anwälten und Mandanten liegt meistens ein Auftragsverhältnis vor. Die Auftragsnehmenden, also in diesem Fall die Anwälte, haften für die Schlechterfüllung ihrer Aufträge. Sie können sich nicht von der Haftung befreien, indem sie sich darauf berufen, dass die KI einen Fehler gemacht hat. Ihre Sorgfaltspflicht wird durch die Nutzung der KI nicht berührt. Da die Sorgfaltspflicht des Nutzenden weiterhin besteht ist zu empfehlen, den Output des KI-System zu prüfen, da die KI halluzinieren und somit ein fehlerhaftes Resultat liefern kann.

Fazit

KI revolutioniert und optimiert Prozesse und macht auch nicht vor der rechtlichen Sphäre halt. Immer mehr Unternehmen und Kanzleien integrieren Legal AI’s in ihre Rechtsabteilungen. Damit die Haftung von den Entwicklern und Benutzern der Legal AI’s bestmöglich abgefedert wird, sollten sich diese der Risiken bewusst sein und angemessene Schritte zur Mitigation treffen.

Die Autoren

Ursula Sury ist selbständige Rechtsanwältin in Luzern (CH) und Vizedirektorin an der

Hochschule Luzern – Informatik. Sie ist zudem als Fachexpertin für Datenschutzaudits der Schweizerischen Vereinigung für Qualitäts- und Management-Systeme (SQS) tätig. Ursula Sury ist hauptsächlich im Bereich Informatikrecht und Datenschutz tätig.

Jean-Pierre Stäheli ist juristischer Mitarbeiter bei der Advokatur Sury AG. Daneben ist er als wissenschaftlicher Mitarbeiter an der Hochschule Luzern – Informatik und als Dozent für Informationssicherheit an der Fernfachhochschule Schweiz tätig.