Daten erfassen, analysieren und daraus Schlussfolgerungen und Aktionen ableiten – das ist im Kern der Dreischritt selbstlernender Systeme. Sie sind die Grundlage für den Übergang von automatisierten zu autonomen und damit wandlungsfähigen Abläufen in der Produktion. Die Ziele: Verbesserung der Gesamtanlagen-Effektivität (Overall Equipment Effectiveness) und der Aufbau neuer digitaler Geschäftsfelder.

In der spanenden Fertigung können beispielsweise Verfahren des maschinellen Lernens die Oberflächengüte eines Werkstücks digital vermessen – Algorithmen und dynamische Regelwerke generieren auf dieser Grundlage Handlungsempfehlungen, oder sie lösen automatische Aktionen aus: etwa das Aussortieren des Werkstücks, die Anpassung nachfolgender Fertigungsschritte oder die Optimierung der Fräsverfahren.

Das Fertigungsunternehmen muss dazu die Produktionslogik und die Produktionsressourcen digital abbilden und mit Zugängen zu den relevanten Qualitäts- und Prozessparametern ausstatten. Durch die Korrelation von Prozessparametern und Qualitätsparametern werden Datenmodelle erzeugt, die eine kontinuierliche Steuerung und Optimierung der Fertigung ermöglichen. Soweit die Theorie. In der Praxis stehen produzierende Unternehmen dabei vor einem Dilemma, das sich aus den Anforderungen an den Daten-Kreislauf ergibt. Diese Anforderungen, das Dilemma und eine Lösungsstrategie werden im Folgenden beschrieben.

Datenkreislauf zwischen Standorten und Zentrale

Die Qualität der Datenmodelle hängt zu grossen Teilen von der Menge und Qualität des Lernmaterials ab. Ein Wartungstechniker wird das genaue Verhalten einer einzelnen Fräsmaschine vor und während eines Fehlers möglicherweise erst nach Jahren so gut kennen, dass er den Fehler frühzeitig identifizieren oder vermeiden kann. Könnte man die Erfahrung mit hunderten oder tausenden gleichen Fräsmaschinen aggregieren, liesse sich der Lernprozess auf Wochen oder gar auf Tage

reduzieren.

Nichts Anderes erfolgt, wenn man Daten aus den gleichen Maschinen oder Produktionsschritten aus unterschiedlichen Standorten erfasst und in ein selbstlernendes Datenmodell einspeist. Je mehr relevante Daten zur Verfügung stehen, desto schneller und besser der Lerneffekt. Man spricht hierbei von Daten-Netzwerkeffekten. Gerade industrielle Daten bergen ein erhebliches Potenzial, um durch solche Effekte nachhaltige Wettbewerbsvorteile aufzubauen. Relevant sind dabei nicht nur die direkt im Fertigungsprozess anfallenden Daten – um beim Beispiel spanende Fertigung zu bleiben: nicht nur Daten zu Oberflächenrauhheit, Fräsverfahren, Vorschub oder Schnitttiefe –, sondern beispielsweise auch Messwerte der Fräsmaschine selbst (zum Beispiel Vibration), Umweltinformationen (zum Beispiel Luftfeuchtigkeit), ausserdem logistische und betriebswirtschaftliche Parameter, etwa aus ERP-Systemen.

Die trainierten Modelle, Algorithmen und Regelwerke steuern im Produktionsablauf die Datenanalyse und Aktion. Je nach Fertigungsverfahren sind dabei geringe Antwortzeiten (Latenz) bis hin zu Echtzeit-Anforderungen eine Bedingung. Deshalb werden die Datenprozesse in der Regel in den Werken nah an Maschine oder Fachsystem ausgeführt. Dabei kommen industrielle Edge-Systeme zum Einsatz, die die Schnittstelle zwischen Industrie- und IT-Systemen bilden. Sie sorgen dafür, dass Analyse und Aktion ohne Datenübertragung an entfernte Rechenzentren oder Clouds erfolgen kann, um eine möglichst hohe Prozessstabilität zu gewährleisten.

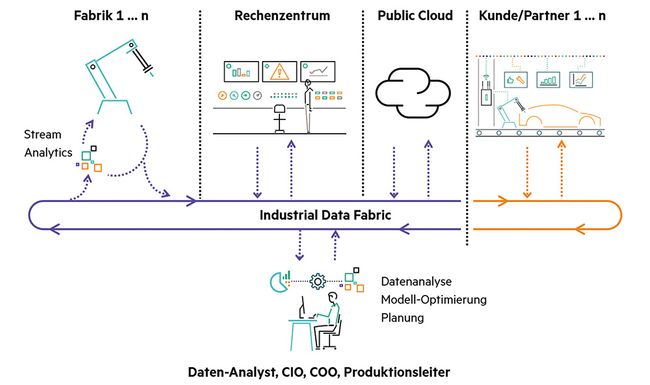

Somit ergibt sich ein permanenter Datenkreislauf zwischen verteilten Fertigungsstandorten und der Zentrale. Die Datenmodelle werden an zentraler Stelle mithilfe der an den Produktionsstandorten entstehenden Daten laufend verbessert. In Produktionsstandorten wiederum werden die vortrainierten Modelle, Algorithmen und Regelwerke für die operative Prozesssteuerung eingesetzt.

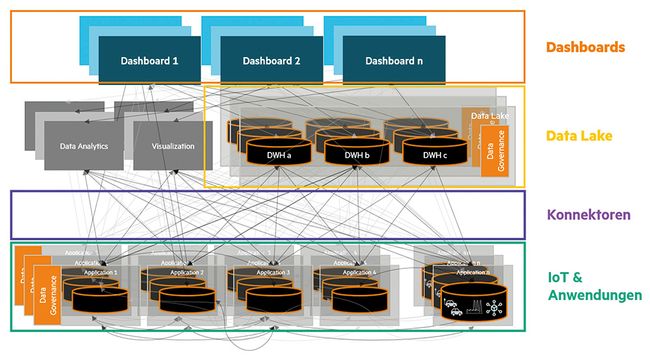

Ein IoT-Best-of-Breed-Ansatz kann die in Fertigungsumgebungen ohnehin schon bestehende Komplexität zementieren oder noch weiter erhöhen – also die typische Spaghetti-Architektur, in der mehrere Datenbanken, Analysewerkzeuge und Applikationen über individuelle Schnittstellen kreuz und quer miteinander verbunden sind. (Quelle: HPE)

Dateninseln und Abhängigkeiten vermeiden

Um einen solchen Datenkreislauf entlang der gesamten Wertschöpfungskette aufzubauen, müssen Daten sowohl vertikal als auch horizontal integriert werden. Bei der vertikalen Integration werden die Daten von Maschinen oder Systemen an zentrale IoT- oder Cloud-Plattformen übermittelt. Das kann beispielsweise die Temperatur und der Vibrationswert mit dem jeweiligen Zeitstempel sein, die regelmässig abgetastet und in einem zentralen System visualisiert oder weiterverarbeitet werden.

Fertigungsunternehmen stehen dabei vor einem Dilemma. Wenn sie in einem Best-of-Breed-Ansatz die IoT-Plattformen ihrer verschiedenen Maschinenhersteller nutzen, können Dateninseln entstehen, die die übergreifende Analyse und Steuerung erschweren. Dabei wird die in Fertigungsumgebungen ohnehin schon bestehende Komplexität zementiert oder noch weiter erhöht – also die typische Spaghetti-Architektur, in der mehrere Datenbanken, Analysewerkzeuge und Applikationen über individuelle Schnittstellen kreuz und quer miteinander verbunden sind. Wenn Unternehmen dagegen zwecks Komplexitätsreduktion nur auf eine oder wenige Cloud-Plattformen setzen, können sie in zu grosse Abhängigkeiten geraten.

Die horizontale Datenvernetzung kann diese Probleme lösen. Dabei werden die Daten nicht an eine zentrale Stelle transferiert, sondern über eine separate Datenschicht miteinander verknüpft. Daher auch der Name Data Fabric, auf Deutsch also Datengewebe oder Geflecht vermischter Datenverbindungen.

Mit einer Data Fabric den Datenkreislauf kontrollieren

Eine Data Fabric vereinigt zum einen verteilte und heterogene Dateisysteme per Abstraktion zu einem einzigen Namensraum (Global Namespace). Ein Produktionsunternehmen erhält damit einen einheitlichen Zugriff auf Daten und Dateien, die auf unterschiedlichste Systeme und beliebig viele Standorte verteilt sein können. Dies ermöglicht ein ganzheitliches Daten-Management, etwa zur Sicherstellung von Zugriffsrechten und anderen Compliance-Anforderungen. Zudem organisiert die Data Fabric den oben beschriebenen Datenkreislauf.

Sie ist also die Drehscheibe, über die Produktionsstandorte, Cloud-Dienste und Partnerunternehmen als Lieferant oder Empfänger von Daten und Analysemodellen in diesen Kreislauf integriert werden.

Mit diesem Ansatz lässt sich somit das Komplexitätsproblem lösen, denn es gibt einen konsolidierten Zugriff auf Daten, und das Zusammenspiel der Anwendungen, Datenquellen und Datenbanken wird über eine einheitliche Datenschicht organisiert. Ausserdem lässt sich damit das Abhängigkeitsproblem lösen, da das Produktionsunternehmen selbst den Kreislauf kontrolliert – und eben nicht externe Plattformen, die Kunden wie eine Spinne in ihr eigenes Netz einbinden. Auch beim Einsatz mehrerer externer Plattformen geht dabei die Einheitlichkeit der Datenarchitektur nicht verloren; ein Produktionsunternehmen kann somit durch eine Multi-Vendor-Strategie seine Abhängigkeit zusätzlich reduzieren, ohne überbordende Komplexität oder Dateninseln fürchten zu müssen.

Bausteine einer Data Fabric

Die Data Fabric beruht auf einer offenen und durchlässigen Architektur. Im Folgenden werden die wichtigsten Bausteine entlang der Prozesskette Akquisition, Aggregation, Analyse und Aktion beschrieben:

Akquisition: Die Datenakquisition geschieht mit Software-Bausteinen, die über Programmierschnittstellen (API) auf Datenbestände zugreifen, etwa auf die SQL-Datenbank des ERP-Systems, die Sensordaten einer Fräsmaschine oder die NoSQL-Datenbank einer Cloud-Applikation. Sie wandeln die jeweiligen Industrieprotokolle in IP-Pakete um und erschliessen somit die Vielfalt der Datenquellen.

Aggregation: Über Daten-Pipelines fliessen die Daten aus Quellsystemen in die Data Fabric, um sie durch Messaging-Systeme den Zielanwendungen zugänglich zu machen. In diesem Zuge erfolgt häufig eine Selektion und Verdichtung der Daten, da in der Regel nicht alle Quelldaten zur Weiterverarbeitung relevant sind. Ausserdem können die Daten in einem sogenannten Data Lake abgelegt werden. Dieser Datensee aggregiert die Fülle heterogener produktionsbezogener Daten, um einen möglichst umfangreichen Datenbestand für das maschinelle Lernen zu schaffen. Anders als ein traditionelles Data Warehouse kann ein Data Lake auf diverse Standorte und Umgebungen verteilt sein – etwa auf Produktionsstandorte, Rechenzentren oder Clouds. Per Mandantensteuerung wird kontrolliert, welche Benutzer in welcher Weise auf welche Datenbestände zugreifen dürfen. So lässt sich der verteilte Data Lake auch über mehrere Firmen hinweg nutzen, ohne die Datenhoheit der beteiligten Firmen zu beeinträchtigen.

Analyse: Mittels Data Taps (Datenzapfhähne) können Datenanalysten sowohl auf die operativ zirkulierenden Daten wie auch auf den verteilten Datensee zugreifen, um mit Datenmodellen zu experimentieren, diese zu trainieren, zu verfeinern und laufend zu aktualisieren. Mittels Stream Analytics – der echtzeitnahen Analyse von Ereignisdatenströmen – kommen die trainierten Modelle dann für die Überwachung der Sensordaten der laufenden Produktion zum Einsatz. Sie erkennen dabei zum Beispiel Abweichungen oder auffällige Häufungen, die auf sich abzeichnende Störungen hinweisen. Stream Analytics ist damit die Grundlage für autonome Aktionen im operativen Betrieb ebenso wie für eher mittelfristige Interventionen, etwa die vorausschauende Wartung.

Aktion: Auf Basis von Algorithmen beziehungsweise Geschäftslogiken werden Aktionen ausgelöst, etwa die Eröffnung eines Service-Auftrags, sofern eine Maschine aufgrund von Verschleiss nicht mehr die gewünschte Qualität produziert. Darüber hinaus können nachgelagerte Prozesse auf Basis dieser Erkenntnis angepasst werden, um die Qualität wieder in den Toleranzbereich zu bringen. Hierbei spricht man von selbstoptimierenden beziehungsweise autonomen Systemen.

Eine Data Fabric kann sowohl das Komplexitäts- als auch das Abhängigkeitsproblem lösen. Ein Produktionsunternehmen erhält damit einen einheitlichen Zugriff auf Daten, die auf unterschiedlichste Systeme und beliebig viele Standorte verteilt sein können. (Quelle: HPE)

Container als technologische Grundlage

Für die Data Fabric kommt Container-Virtualisierung als technologische Grundlage zum Einsatz. Damit lässt sich die Geschäftslogik der Data Fabric über Produktions- und Logistik-Standorte, Rechenzentren und Clouds verteilen und einheitlich betreiben. Container und Container-Orchestrierung mit Kubernetes sind heute die Mittel der Wahl, um verteilte und weitgehend plattformunabhängige Anwendungen aufzubauen. Dabei lässt sich heute auch das Problem der Daten-Persistenz lösen, sodass auch monolithische Applikationen – etwa MES oder PPS – containerisiert werden können. Unternehmen erreichen damit den unschätzbaren Vorteil einer homogenen Umgebung mit entsprechenden Effizienz- und Transparenzvorteilen im Betrieb.

Beim Aufbau einer solchen Data Fabric muss jedes Unternehmen für sich die Frage «make or buy» beantworten. Es stehen heute eine Fülle von Technologien und Open-Source-Werkzeugen zur Verfügung, mit denen ein Unternehmen eine Data Fabric in Eigenregie aufbauen kann. Die Alternative dazu sind kommerzielle Standardprodukte. Dabei handelt es sich um massiv skalierbare verteilte Dateisysteme, mit denen sich auch Datenbestände im Petabyte-Bereich performant bewältigen lassen. Zudem unterstützen solche Plattformen die Analyse verteilter Datenbestände und bieten Funktionen für die persistente Speicherung von Daten in Container-Umgebungen.

Fazit

Mit einer Data Fabric können produzierende Unternehmen die Netzwerk-Effekte schaffen, die erforderlich sind, um das Wertschöpfungspotenzial ihrer Daten zu erschliessen – etwa in Form von erhöhter operativer Effizienz, oder indem das Unternehmen selbst zur Plattform wird, das seinen Kunden digitale Dienste anbietet. Die Data Fabric stellt die Datendrehscheibe dar, die den Austausch und die Kontrolle von Daten und Prozesslogik ermöglicht. Dabei lassen sich auch externe Datenquellen anzapfen, und man kann externen Parteien einen kontrollierten Zugriff auf eigene Datenquellen gewähren. Damit sind auch firmenübergreifende Netzwerkeffekte möglich.

Firmen bleiben dabei weitestgehend unabhängig von zentralen IoT- oder Cloud-Plattformen, da sie Netzwerkeffekte über eine dezentrale Architektur erreichen, die sie selbst kontrollieren. Externe Cloud-Dienste bleiben gleichwohl unverzichtbare Ressourcen, denn sie verfügen über vorzügliche Werkzeuge und Aggregations-Möglichkeiten. Sie können aber aus einer Position der Souveränität heraus genutzt werden, also mit Hoheit über die Daten und die daraus entstehende Wertschöpfung.

Der Autor

Florian Doerr leitet die Edge-Practice von

Hewlett Packard Enterprise in Deutschland, Österreich und der Schweiz. In dieser Rolle ist er verantwortlich für die Kundenberatung und Lösungsentwicklung für dezentrale digitale Umgebungen wie Smart Factories oder Smart Cities. Davor war er Lead Solution Architect für Data Analytics. Doerr begann seine Laufbahn bei HP im Jahr 2005 als Teilnehmer des dualen Studiums im Fach Wirtschaftsinformatik und machte später seinen Master im Fach IT-Management.

Florian Doerr leitet die Edge-Practice von Hewlett Packard Enterprise in Deutschland, Österreich und der Schweiz. (Quelle: HPE)