Moderne Workloads wie Big Data Analytics, Maschinelles Lernen (ML) und Künstliche Intelligenz (KI) werden immer wichtiger. Das Echtzeit-Design vieler dieser Systeme erfordert einen All-Flash-Speicher, um eine geringe Latenz und einen hohen Durchsatz zu erreichen. Da IT-Abteilungen immer mehr dieser Workloads auf sehr grossen und schnell wachsenden Datensätzen einsetzen, benötigen sie neue, leistungsfähigere Speichertechnologien.

In den letzten Jahren haben sich All-Flash-Arrays im Speichermarkt etabliert. Das Non-volatile-Memory-Express (NVMe)-Protokoll, das von Grund auf für die Parallelverarbeitung entwickelt wurde, gibt All-Flash einen weiteren Schub. NVMe-over Fabrics (NVMe-oF) ermöglicht superschnellen Speichernetzwerken die Konsolidierung mehrerer Workloads in einer Speicherumgebung.

Aktuelle Trends und Potentiale im Storage-Markt

Die fortschreitende Storage-Innovation im Rechenzentrum führt unweigerlich zu Disruption durch den Übergang von alten zu neuen Technologien: von der Festplatte zu Flash, vom Storage Area Network (SAN) oder Direct Attached Storage (DAS) zu Ethernet, von Disk-to-Disk-to-Tape (D2D2T) zu Flash-to-Flash-to-Cloud (F2F2C) und von On-Prem oder Cloud zu Hybrid-Umgebungen. Bereits heute stellt sich die Frage, ob traditionelle SAN- und DAS-Systeme obsolet geworden sind und was an ihre Stelle treten wird.

Vor allem Service Provider bewegen sich auf Ethernet-Netzwerke zu. Die Technologie ist erschwinglich und moderne Scale-Out/Cloud-basierte Anwendungen basieren bereits auf Fast Ethernet Fabrics. Auf diese Weise können die Verfügbarkeits- und Effizienzvorteile eines gemeinsamen Arrays genutzt und gleichzeitig kann maximale Performance erreicht werden. Der Vorteil dabei ist die Konvergenz im Netzwerk. Darüber hinaus hat sich die Geschwindigkeit von Ethernet, derzeit bei 100 Gbit/s, in den letzten Jahren massiv erhöht. Über diese Infrastruktur ist es auch möglich, nicht nur iSCSI- oder NAS-Protokolle, sondern auch Objekt-basierte Protokolle anzusprechen. Ethernet eröffnet auch Möglichkeiten für neue Anwendungen, die über NVMe-oF mit der Storage-Umgebung verbunden werden können.

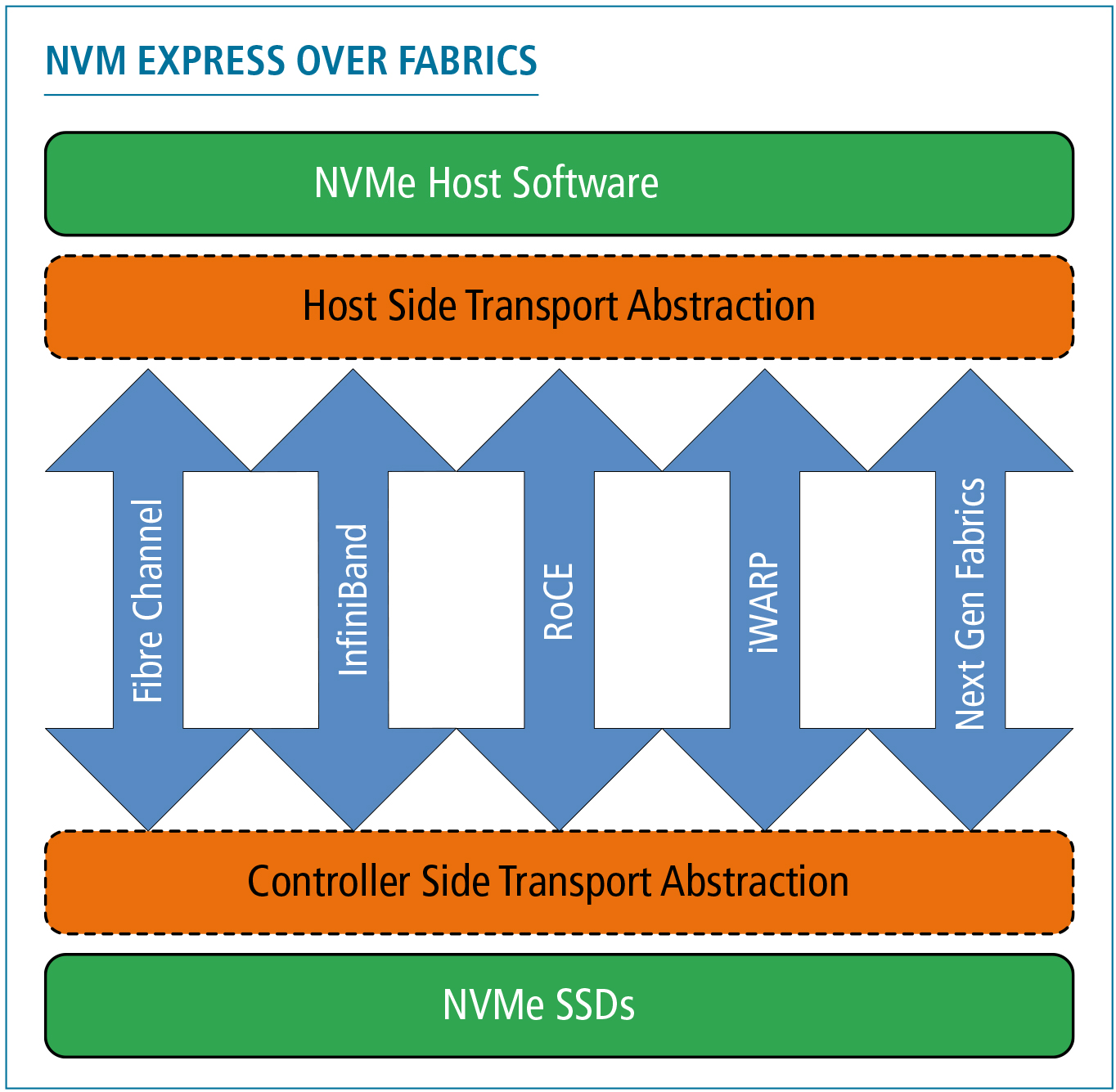

NVMe-oF ist eine Erweiterung von NVMe zur Unterstützung von Netzwerkstrukturen wie Ethernet, Fibre Channel, Infiniband und TCP. (Quelle: Wikimedia Commons)

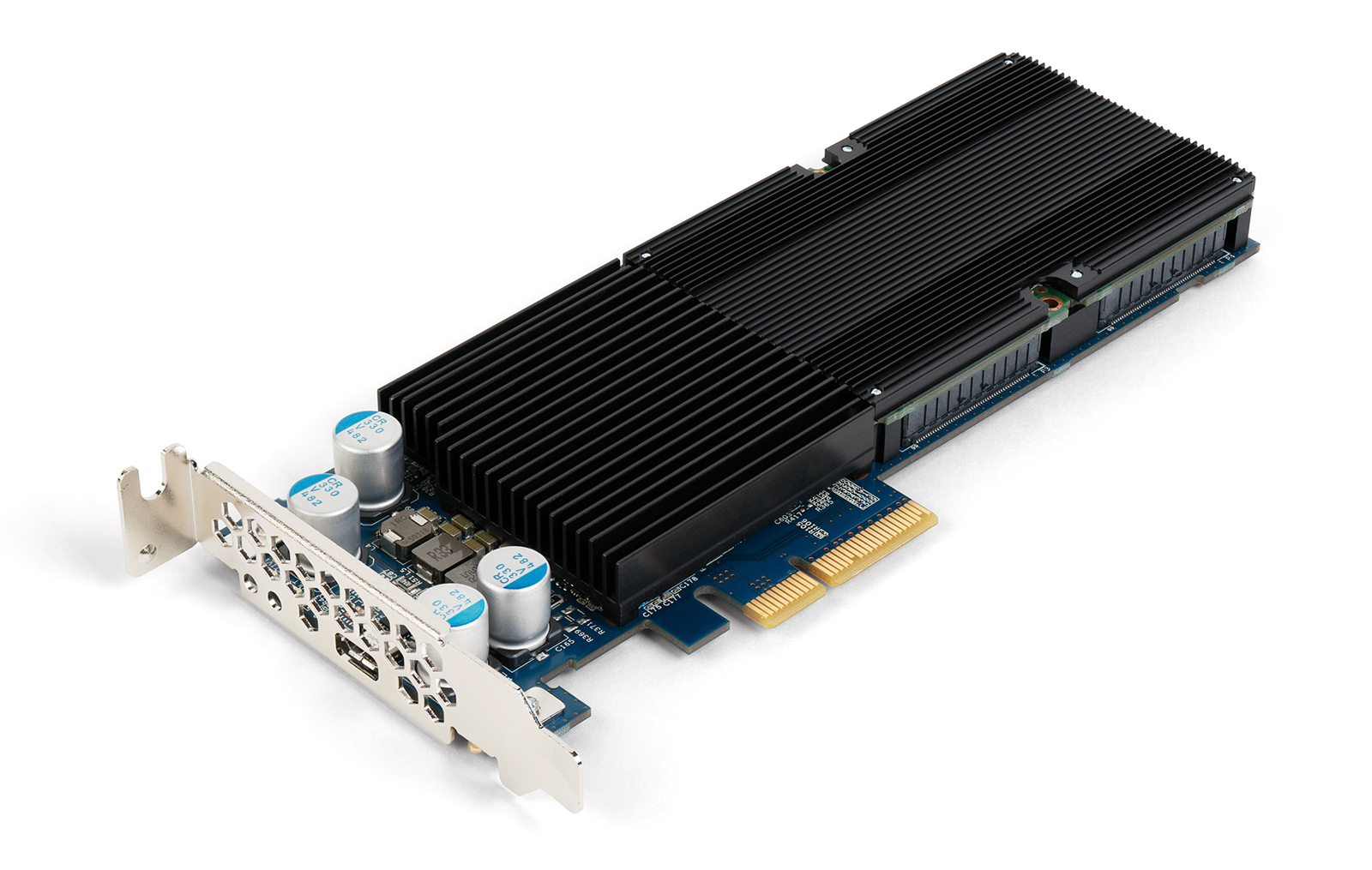

NVM Express ist eine offene Geräteschnittstelle für den Zugriff auf nichtflüchtige Speichermedien. (Quelle: Wikimedia)

NVMe als wichtige Storage-Innovation

In den letzten Jahren hat sich NVMe zu einer bedeutenden Innovation im Storage-Umfeld entwickelt. NVMe ist ein Protokoll der nächsten Generation für eine beschleunigte Kommunikation zwischen Prozessor und Flash-Speicher. Der Einsatz von NVMe war zunächst auf den Endverbrauchermarkt, insbesondere Smartphones, beschränkt und wurde auf grosse Enterprise-Storage-Lösungen ausgeweitet. Seitdem hat sich NVMe in den Mainstream-B2B-Markt vorgearbeitet, in Form von Speicherlösungen, die für kleine und mittelständische Unternehmen mit hohen Anforderungen an die Datenverarbeitung attraktiv sind.

Für Flash-Arrays der Enterprise-Klasse bietet NVMe eine weitaus höhere Leistung als die zuvor entwickelten Serial-Attached-SCSI- (SAS)- und Serial-Advanced-Technology-Attachment- (SATA)-Schnittstellen. Diese wurden ursprünglich für Festplatten entwickelt, sind aber immer noch weit verbreitet, selbst in All-Flash-Solid-State-Laufwerken. Der Grund für den Leistungssprung ist, dass NVMe deutlich schneller ist als das herkömmliche Speicherprotokoll SAS. Es unterstützt bis zu 64’000 parallele Warteschlangen mit 64’000 Befehlen pro Warteschlange, womit direkte Übertragungswege zum Flash-Speicher zur Verfügung stehen. Auf diese Weise stehen direkte Übertragungswege zu Solid State Drives (SSDs) bereit. Die daraus resultierende massive Parallelverarbeitung beseitigt die durch serielle Verbindungen verursachten Engpässe. Dies führt zu einer deutlich höheren Performance.

NVMe ermöglicht, was den Datenzugriff betrifft, effizientere und schnellere All-Flash-Systeme im Vergleich zu herkömmlichen Festplatten. Einige der Storage-Anbieter treiben die Transformation zu NVMe voran, mit dem Ziel, NVMe als führendes Schnittstellenprotokoll für Flash zu etablieren.

Schnellere Konnektivität mit NVMe-oF

NVMe-oF ist ein zusätzliches neues Protokoll für viel schnellere Verbindungen von Server zu Speicher. NVMe-oF ist eine Erweiterung von NVMe zur Unterstützung von Netzwerkstrukturen wie Ethernet, Fibre Channel, Infiniband und Transmission Control Protocol (TCP). Der Fabric-Ansatz kombiniert die gemeinsame Netzwerkstruktur von Core-, Aggregations- und Edge-Layern in einer Umgebung, zugunsten einer flexiblen Rechenzentrumsinfrastruktur.

NVMe-oF bietet eine schnellere Verbindung zwischen Speicher und Anwendungen auf Servern und eine effizientere CPU-Auslastung. Dies erlaubt eine weitere Konsolidierung von Rechenzentrum und Netzwerk, da Infrastruktursilos mehrerer Anwendungen eine einzige effiziente Speicherinfrastruktur nutzen können. Dieses gemeinsame Speichernetzwerk beschleunigt den Zugriff und verbessert die Bandbreite. Mit NVMe-oF kann externer Speicher eine Latenz erreichen, die mit DAS vergleichbar ist. NVMe-oF ist bei der Speicher-I/O-Verarbeitung deutlich effizienter als iSCSI und erhöht die Parallelität der Gesamtarchitektur, wodurch Engpässe vermieden werden.

25/50G- und 100G-Ethernet-Switches, die Data Center Bridging (DCB) unterstützen, ermöglichen eine hohe Speicherleistung auf Ethernet-Fabrics der Enterprise-Klasse. Insbesondere NVMe-oF mit RoCEv2 (RDMA over Converged Ethernet) hat das Potential, DAS-Speicher in vielen Unternehmensumgebungen zu ersetzen. Dank NVMe-oF bleibt Fibre Channel eine Option.

Die direkte Flash-Fabric-Konnektivität ist eine Schlüsselkomponente, die Unternehmen bei der Vereinheitlichung von SAN, DAS und Cloud unterstützt und die Leistung geschäftskritischer Anwendungen und neuer Web-Scale-Anwendungen verbessert. Durch die Unterstützung von NVMe-oF mit RoCE können Unternehmen Flash-Medien näher an Anwendungen heranführen und so den Echtzeit-Zugriff und die Konsolidierung verbessern. Damit ist Ethernet eine erstklassige Rechenzentrumskomponente für Storage mit bis zu 50 Prozent Latenzreduzierung gegenüber iSCSI. NVMe-oF sorgt generell für eine höhere Effizienz im gesamten Netzwerk. Dies gilt insbesondere in Kombination mit Linux und nativen Web-Scale-Anwendungen wie MongoDB, Cassandra und MariaDB, die die Vorteile und die Effizienz von Shared Storage der Enterprise-Klasse nutzen.

Insbesondere Cloud-native Anwendungen erhalten mit End-to-End NVMe-oF im Vergleich zu SAS-basierten DAS-Lösungen einen deutlichen Leistungsschub. Die eigenen Tests von Pure Storage zeigten eine 50-prozentige Steigerung der Operations Per Second (OPS) auf MongoDB. Bei Cassandra wurde eine 30-prozentige Verbesserung der Latenz und der OPS erreicht, und bei MariaDB eine 33-prozentige Steigerung der maximalen Transaktionen.

Ein weiterer Anwendungsfall wäre zudem sicher auch die Entwicklung einer neuen Test- oder Entwicklungsumgebung auf Basis der aktuellen MongoDB-Daten aus der Produktion. Mit DAS müssten die Daten aus einer Sicherung kopiert oder wiederhergestellt werden. Die direkte Flash-Fabric-Verbindung ermöglicht es derweil, Instanzen sofort aus einem Snapshot heraus zu erstellen, ohne die Produktion zu beeinträchtigen oder zusätzliche Kapazität zu benötigen. All dies kann über eine Rest-API automatisiert werden.

All-Flash als Speicherziel für Backup & Recovery?

Im Zusammenhang mit der Entstehung von Daten als wertvollstem Vermögenswert eines Unternehmens gewinnt die Datensicherung immer mehr an Bedeutung. Das herkömmliche Backup-Modell Disk-to-Disk-to-Tape (D2D2T) entspricht nicht mehr den aktuellen Anforderungen, insbesondere in Bezug auf die schnelle Datenwiederherstellung. Die primäre Festplatte erstellt ein lokales Backup auf der sekundären Festplatte oder einer Purpose-Built Backup-Appliance (PBBA). In der Regel folgt dann die Sicherung auf separate Bandmedien oder die Replikation auf eine andere Appliance an einem externen Standort für Disaster-Recovery-Zwecke. Dies führt zu mehreren Backup-Silos und einer teuren, dedizierten Infrastruktur, die nur für die Sicherung ausgelegt ist. Die auf Band gesicherten Daten sind kalt, sie können nicht in Echtzeit abgerufen und verwendet werden. Hinzukommt die empfindliche Datenbeständigkeit auf Band und die zusätzliche Hardware, die für die Bandsicherung benötigt wird.

Im Gegensatz zum herkömmlichen Ansatz sorgt F2F2C für eine schnellere Wiederherstellung immer grösserer Datensätze und vereinfacht den IT-Betrieb. Das primäre Flash-Speichersystem, beispielsweise mit Oracle oder Vmware, sichert auf Flash-basierten Sekundärspeicher – für schnelle Wiederherstellungen – und die Backup-Daten werden ebenfalls in der Public Cloud gespeichert. Durch Komprimierung und Deduplizierung können Backup-Daten sowohl vor Ort als auch in der Cloud äusserst effizient gespeichert werden. Dieser Ansatz zeichnet sich aus durch schnellere und flexiblere Wiederherstellungen, eine sichere langfristige Aufbewahrung von Backup-Daten und eine einfachere Handhabung. Eine schnelle Wiederherstellung findet in der lokalen Umgebung statt, während Backup-Daten in der Public Cloud automatisch zur Unterstützung von Wiederherstellungsvorgängen oder zur Notfallwiederherstellung verwendet werden, wenn lokale Daten nicht verfügbar sind.

Moderne Backup-Lösung: Flash in Kombination mit Cloud

Neue Speicherlösungen bieten ein einheitliches hybrides Cloud-Erlebnis, einheitliche APIs und Automatisierung für Entwickler sowie Backup- und Datensicherungs-Optionen in der Public Cloud. Bei der Interaktion zwischen On-Prem und der Public Cloud ging es darum, eine Lücke zu schliessen: Die Cloud ist nicht speziell für Unternehmensanwendungen konzipiert, und die Unternehmensinfrastruktur ist nicht so einfach zu bedienen wie die Cloud.

Die Datensicherungsarchitektur der nächsten Generation sollte auf Scale-Out-Speichersystemen basieren, die von Grund auf für unstrukturierte Daten entwickelt wurden und eine beispiellose Leistung für eine Vielzahl von Workloads bieten. Schnelle Backups und Wiederherstellungen, aber auch Test/Dev- und Analytik-Anwendungen können auf einer einzigen Speicherplattform zusammengefasst werden. All dies kann nahtlos in einer einheitlichen Hybrid-Cloud-Umgebung erfolgen. Die Storage-Plattform muss daher konsistente Speicherdienste, Ausfallsicherheit und APIs für lokale Umgebungen und mehrere Cloud-Modelle bereitstellen.

Einheitliches Datenmanagement mit Flash-Performance

Die Mobilität von Unternehmensanwendungen in Kombination mit neuen anspruchsvollen Anwendungen hat die strategische Bedeutung der Infrastruktur exponentiell erhöht. Die Antwort ist ein einheitliches Datenmanagement für beide Umgebungen, das durch APIs und Integrationen realisiert wird. Dieser Ansatz erlaubt es, On-Prem-Features wie Hochverfügbarkeit in die Cloud zu bringen und umgekehrt ein Pay-per-Use-Modell wie die Public Cloud in der On-Prem-Infrastruktur anzubieten.

Eine kleine Anzahl von Storage-Anbietern unterstützt ihre Kunden bereits bei der Anbindung an Public Clouds wie Azure und AWS sowie durch Schnittstellen, die es ihnen ermöglichen, Anwendungsfälle wie Backup, Test/Entwicklung oder Disaster Recovery in der Cloud nahtlos umzusetzen. Erfolgreiche Ansätze sind hierbei das Provisioning über eine REST-API oder ein Upgrade-Programm als Abonnementmodell, das Flash-Arrays auf dem neuesten Stand hält.

Neue Datenservices, die seit kurzem verfügbar sind, erleichtern den Umgang mit Anwendungsfällen zwischen On-Prem- und Cloud-Umgebungen. Ein Beispiel wäre die Sicherung von Speicher-Snapshots aus einem Flash-Array auf AWS S3- und Network-File-System- (NFS)-Ziele. Sobald sich die Daten in Amazon S3 befinden, können sie in der Amazon Cloud für Wiederherstellungs-, Disaster-Recovery- oder Test- und Entwicklungs-Zwecke rehydriert werden. Die Portabilität von Snapshots unterstützt somit den Ansatz, die Anforderungen des Multi-Cloud-Modells optimal zu erfüllen. Die richtige Datenstrategie ist entscheidend, denn Daten sind der Schlüssel zu effizienter Entwicklung und Anwendungsmobilität. Heute können Unternehmen ihre Dateninfrastruktur optimal auf ihre Anwendungen abstimmen. Eine datenzentrierte, einheitliche Hybrid-Cloud-Architektur ist ein tragfähiges, zeitgemässes und zukunftsweisendes Modell. Es gibt modernen Unternehmen die nötige Agilität und schafft die Grundlage für die Unterstützung neuer, anspruchsvoller Anwendungen.

Der Autor

Markus Grau ist Principal Systems Engineer im EMEA CTO Office bei Pure Storage. Seine Laufbahn beim Experten für Flash-Speichersysteme begann er im Frühjahr 2014 als Systems Engineer. Zuvor war Markus Grau rund acht Jahre bei Netapp beschäftigt, wo er vom Systems Engineer zum Solutions Architect aufstieg. Seine Karriere begann Markus Grau bei Case, von wo aus er im Jahr 2000 zu Computerlinks (heute Arrow) wechselte.